16 Aug, 2010 von Benjamin Erb 1

Effiziente Bereichs-Queries mit CouchDB/GeoCouch

Im Vergleich zu klassischen SQL-Datenbank erfordern NoSQL-Datenbank vor allem bei der Datenabfrage ein Umdenken. Im Falle von CouchDB lässt sich zwar mit View Collation schon einiges erreichen, allerdings bei weitem nicht alles. Auf eine solche Grenze bin ich gestoßen, als ich Zeiträume speichern und abfragen wollte, also Einträge die ein Start- und Enddatum besitzen. Anfragen auf diese Daten könnten nun zu einem fixen Zeitpunkt alle darin ablaufenden Einträge erfragen, oder ausgeweitet auf einen Zeitraum auflisten, welche Einträge innerhalb eines Zeitfensters liegen. All dies ist mit CouchDB nicht wirklich lösbar.

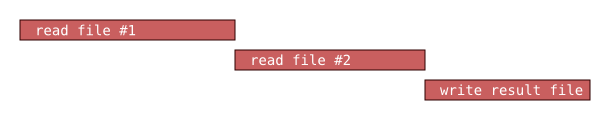

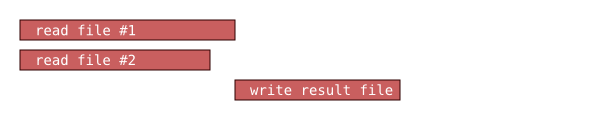

Einen kleinen Workaround bietet die Idee, die Zeitleiste zu segmentieren und immer dann für einen Eintrag einen Key zu emitten, wenn der Zeitraum des Eintrages innerhalb dieses Bereichs liegt. Eine solche Map-Funktion könnte wie folgt aussehen. Hierbei wird für einen Eintrag jeweils ab dem Beginn für alle 5 Minuten ein Schlüssel in den Index emittiert.

Dokumentaufbau:

{

"_id": "s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de",

"begin": "2010-08-05T09:11:52.156Z",

"end": "2010-08-05T09:23:13.457Z"

}

Map-Funktion:

//length of time segment (here 5 min)

var periodLength = (60*5);

function(doc)

{

if(doc.begin && doc.end)

{

//start and end time as UNIX timestamps (seconds, not milliseconds)

var begin = Math.round(new Date(doc.begin).getTime()/1000);

var end = Math.round(new Date(doc.end).getTime()/1000);

//calculate first matching segment of period

var p = (begin - (begin%periodLength));

//emit key for each matching period

while(p<=end)

{

emit([p, doc._id], null);

p = p + periodLength;

}

}

}

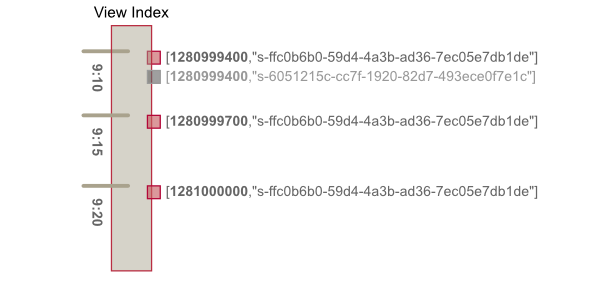

Der resultierende View sieht dann in etwa so aus:

Oder als Abfrage:

http://localhost:5984/entries/_design/entries/_view/docsByPeriodList?startkey=[1280998800]&endkey=[1281000193,{}]

{"total_rows":3,"update_seq":2,"offset":0,"rows":[

{"id":"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de","key":[1280999400,"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de"]15,"value":null},

{"id":"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de","key":[1280999700,"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de"],"value":null},

{"id":"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de","key":[1281000000,"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de"],"value":null}

]}

Eine viel bessere Lösung bietet jedoch die CouchDB-Erweiterung GeoCouch. Dank des R-Trees lassen sich Bereichtsabfragen effizient durchführen. Da GeoCouch eigentlich für zweidimensionale Geokoordinaten gedacht, muss sie und die GeoJSON-Syntax etwas missbraucht werden. Anstatt einer WGS84-Koordinate emittieren wir einfach einen UNIX-Zeitstempel und lassen den anderen Grad leer:

function(doc)

{

if(doc.begin && doc.end)

{

//start and end time as UNIX timestamps (seconds, not milliseconds)

var begin = Math.round(new Date(doc.begin).getTime()/1000);

var end = Math.round(new Date(doc.end).getTime()/1000);

emit(

{

type: "Point",

bbox : [0,start,0,end]

}, null

);

}

}

So lassen sich nun effiziente Bereichsabfragen durchführen:

http://localhost:5984/entries/_design/entries/_spatial/entriesByPeriod?bbox=0,1280998800,0,1281000600

{"update_seq":16,"rows":[

{"id":"s-ffc0b6b0-59d4-4a3b-ad36-7ec05e7db1de","bbox":[0,1280999512,0,1281000193],"value":null}

]}