25 Feb, 2012 von Raimar Wagner 0

Graphen & Plots erzeugen mit GLE

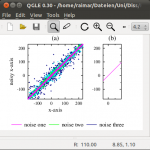

Nicht unerheblich für eine erfolgreiche Veröffentlichung ist eine ansprechende Präsentation der Ergebnisse. Jeder schaut sich lieber schöne Plots mit den zum Latex Template passenden Schriftarten an. Eine Möglichkeit solche Plots zu erzeugen ist über die Skriptsprache GLE die auch gleich eine eingebaute Preview Komponente mitbringt.

Nicht unerheblich für eine erfolgreiche Veröffentlichung ist eine ansprechende Präsentation der Ergebnisse. Jeder schaut sich lieber schöne Plots mit den zum Latex Template passenden Schriftarten an. Eine Möglichkeit solche Plots zu erzeugen ist über die Skriptsprache GLE die auch gleich eine eingebaute Preview Komponente mitbringt.

Ein möglicher Beispielplot ist rechts gezeigt, das dazugehörige GLE Skript unten. Gelesen werden die Daten einfach aus CSV-Dateien.

size 9 6

set font pstr !meine Paper Vorlage verwendet diesen Font.

set texlabels 0 !keine Tex-Fonts in den Labels

!eine Funktion für einen Scatterplot

sub draw_scatter dataset$ mu sigma dt dst letter$

begin graph

size 5 5

!Achsen in mu+-sigma

xaxis min mu-sigma max mu+sigma dticks dt dsubticks dst

yaxis min mu-sigma max mu+sigma dticks dt dsubticks dst

xtitle " x-axis "

ytitle "noisy x-axis"

!Buchstabe als Alternative zu subplots

title letter$

!CSV files lesen & plotten

data dataset$+"_4.csv" d1

d1 marker dot msize 0.2 color navy

data dataset$+"_3.csv" d2

d2 marker dot msize 0.2 color cyan

data dataset$+"_2.csv" d3

d3 marker dot msize 0.2 color lime

data dataset$+"_1.csv" d4

d4 marker dot msize 0.2 color magenta

end graph

end sub

!Zeichnet einen Linienplot

sub draw_line dataset$ mu sigma dt dst letter$

begin graph

xaxis min mu-1/3*sigma max mu+1/3*sigma dticks dt dsubticks dst

yaxis min mu-sigma max mu+sigma dticks dt dsubticks dst

size 1/3*5 5

data "lines-"+dataset$+"-1.csv" d1

d1 line color magenta

title letter$

end graph

end sub

!die plots an die richtigen Positionen zeichnen

amove 1 1.2

draw_scatter "csvdata1" 29 200 100 50 "(a)"

amove 6.3 1.2

draw_line "csvdata1" 29 200 100 50 "(b)"

Für einen Preview die .gle Datei im mitgelieferten Tool qgle öffnen, die .gle Datei kann on-the-fly geändert und gespeichert werden. Die qgle Komponente aktualisiert sich automatisch neu. Für eine Veröffentlichung muss nur die .eps Datei exportiert werden, die Schriftart mittels eps2pdf eingebettet werden.