13 Nov, 2011 von Gastautor 0

Verschätzte Wahrscheinlichkeiten

Dieser Gastbeitrag wurde verfasst von Marcus Bombe:

In meinem vorherigen Artikel sprach ich viel über eine scheinbar widersprüchliche Aufgabenstellung aus der Wahrscheinlichkeitsrechnung, die in Wahrheit nur nicht vollständig war. In diesem Artikel nun will ich die Problematik mit einem einigermaßen realistischen Beispiel unterfüttern.

Tom hatte einen tollen Urlaub in Absurdistan. Erst als er wieder in Frankfurt landet erhält er die schlimme Nachricht: In Absurdistan ist die absurdianische Grippe ausgebrochen! Es handelt sich hierbei um eine tödliche Infaktion, die eine lange Inkubationszeit hat und zu beginn keine sichtbaren oder spürbaren Symptome hat. Folglich muss nun jeder Tourist aus Absurdistan und den Nachbarländern getestet werden, also auch Tom. Ein Arzt nimmt ihm Blut ab und es wird ein Schnelltest durchgeführt. Dieser Schnelltest hat folgende Eigenschaften:

- Der Test hat als Ergebnis entweder “Infiziert” oder “Nicht infiziert”

- 99% aller Infizierten werden als solche erkannt (Fachbegriff: Sensitivität)

- 99% aller Gesunden werden als solche erkannt ( Fachbegriff: Spezifität)

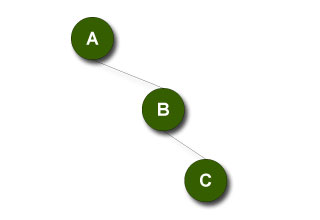

Zudem nehmen wir an, dass es sich hierbei um ein unabhängiges Zufallsexperiment handelt. Wird Blut von derselben Person nochmal getestet, so sind die Chancen wieder 99% korrekt zu 1% inkorrekt. Es ist also _nicht_ so, dass einmal falsch klassifiziertes Blut mit einer höheren Wahrscheinlichkeit wieder falsch klassifiziert werden würde. Aber zurück zu Tom, der sitzt im Warteraum des Arztes und wartet auf sein Ergebnis. Sorgen macht er sich eigentlich keine, weil ihm gehts gut und er hatte auch keinen Kontakt zu krank wirkenden Personen. Nach einer Stunde wird Tom zum Arztgespräch gebeten und zu seinem großen Unglück eröffnet ihm der Arzt, dass der Text positiv sei, er also laut dem Text infiziert sei. Aber kein Grund zur Sorge, machmal irre sich der Test, meinte der Arzt und nahm Tom nochmals Blut für einen zweiten Schnelltest ab. Wieder wartet Tom eine Stunde, diesmal fühlt sich die Zeit schon wesentlich länger an. Nach etwas mehr als einer Stunde wird er wieder zum Gespräch gebeten. Der Arzt bittet Tom, platz zu nehmen, denn er habe eine schlechte Nachricht. Auch der zweite Test ist positiv ausgefallen!

Frage: Wir große Sorgen sollte Tom sich nun machen? Wie wahrscheinlich ist es, dass Tom tatsächlich infiziert ist? Diese Frage sollte der Leser nun für sich selbst beantworten, bevor wir fortfahren. Ist es um die 99%? Oder eher um die 98%? Vielleicht sogar nur 95%? Was sagt das Bauchgefühl?

Alles falsch. Auch hier fehlt wieder eine notwendige Angabe. Mit der sogenannten Prävalenz bezeichnen Mediziner das Verhältnis zwischen der Anzahl der tatsächlich Kranken und der Anzahl aller Untersuchter. Und genau diese Werte fehlen uns. Also dichten wir sie unserer Geschichte hinzu: Die absurdianische Grippe ist glücklicherweise wenig infektiös und Absurdistan ist nicht dicht besiedelt, daher hat es nur 1 von 100.000 Touristen erwischt. Insgesamt wurden eine Million Touristen aus Absurdistan und den angrenzenden Ländern untersucht. Betrachten wir nun also die Abläufe des Tests für alle diese Menschen:

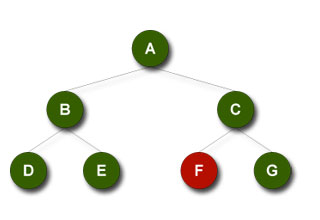

- 1.000.000 Menschen teilen sich auf in 10 Erkrankte und 999.990 Gesunde.

- Von den 10 Erkrankten wurden im ersten Test alle (genau genommen: 9,9) als erkrankt erkannt. Auch ein zweiter Test ändert daran nichts. Folglich sind nach zwei Test 10 tatsächlich kranke als Krank erkannt worden.

- Von den 999.990 Gesunden werden im ersten Test 999.990 * 0,01 ~= 10.000 fälschlicherweise als krank erkannt. Der Rest darf gehen. Die 10.000 im ersten Test falsch erkannten werden nochmals getestet. Im zweiten Test werden 9.900 der 10.000 richtigerweise doch als Gesund erkannt, aber 10.000 * 0,01 = 100 Personen werden ein zweites mal fälschlicherweise als krank eingestuft.

- Fazit: 110 nach zwei Tests als Krank erkannte, jedoch nur 10 tatsächlich erkrankte.

Wenn wir dies nun in einer Wahrscheinlichkeit ausdrücken wollen, so ist Tom nur mit 10/110 ~= 9%-iger Wahrscheinlichkeit infiziert. Glück für Tom.

Tatsächlich gibt es diese Problematik in der Praxis, Wikipedia rechnet dies am Beispiel von DNA-Tests durch. Der Artikel http://de.wikipedia.org/wiki/Pr%C3%A4valenzfehler gibt hierbei einen guten Einblick, wie belastend ein DNA-Test alleine ist. Angelehnt ist der Artikel an http://de.wikipedia.org/wiki/Sensitivit%C3%A4t#HIV_in_der_BRD sowie an einen Abschnitt aus dem Buch “Der Hund der Eier legt” [http://www.amazon.de/Hund-Eier-legt-Hans-Peter-Beck-Bornholdt/dp/3499611546], was ich nur wärmstens empfehlen kann.