29 Jan, 2013 von Michael Müller 1

Interview: Boris ‘krt’ Kraut

I got to know Boris a while ago through a common friend. He is quite active at the “Chaos macht Schule” program and I found him to be quite an interesting person, meaning that he deviates from the mindset and opinions of average people. He regularly writes texts, which are online accesible here. After I talked to him at the GPN ’12 I asked him if he would like to participate in this series and he agreed. So here you go!

Who are you and what do you do?

My name is Boris ‘krt’ Kraut, but it could as well be anything else: You don’t choose your name, it is given to you by others. Even if you pick your name by yourself, e.g. a nickname, you can’t enforce its usage. In fact, sometimes you have to earn your name. Imagine a world where we all are numbers and you have to behave to earn the right to have a name. Sounds fucked up? It sure is! But have a closer look at reality: We just are labeled numbers, because what really matters is your ‘score’. Despite everything you have been told, nobody cares about you, your strengths, your weaknesses, yourself anymore. It’s all about receiving scoring ‘higher’ on somewhat standardized tests to get a ‘better’ chance to earn ‘more’ money to have ‘more’ free-time. This makes me sad.

So, what do I do? I follow a philosophy to improve everywhere: If there is a problem you can fix without negative consequences, it doesn’t matter if it’s your job or not. Just fix it. Sure, you can’t fix everything — either because you just are not able to or because you have something better/more important to do. It’s just that you can improve so much with little to no costs. We shouldn’t miss those opportunities. In the past years I have been focusing on ‘computer/media literacy’, especially the educational system in a digital millennium.

I study at the University of Education, Karlsruhe, and participate in the ‘Chaos macht Schule‘ movement. I like swimming and support the local lifeguards (DLRG), but I resigned from active duty due to my lack of time.

Which software or programs do you use most frequently?

Tough questions. We are all using software all the day, we know what our work setup is like, which programs we use on a daily base, but we often miss the underlying complexity of the operating systems. Even if we don’t use our laptop or smartphone, we are using software, we are depending on software each day: Taking the bus? Guess what, you are using software. Doing the laundry? Software. Reading a book? Hell, yeah, somewhere in the process of writing, printing, delivering and reading it, there is likely software involved…

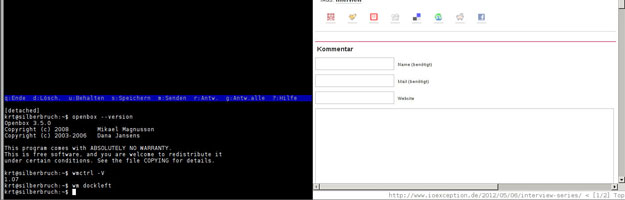

..but to answer your question in a more convenient way I’d pick ‘openssh’,’dtach‘, ‘vim’, ‘mutt’ and ‘firefox’.

Why did you decide to use your particular operating system(s) of choice?

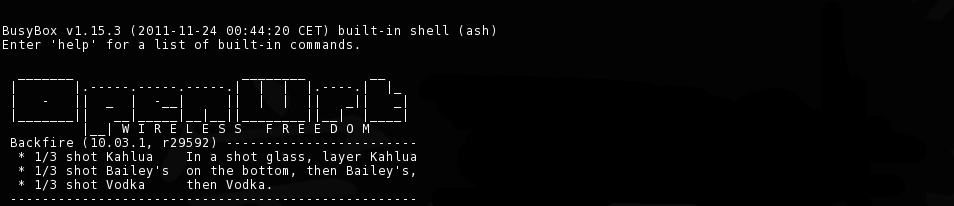

Postponing my answers for a while turns out to be right: I can proudly say I am no longer with Ubuntu anymore. Don’t get me wrong, it’s not that bad, it even might just be the OS which fits you, but the reason I had to use it was a fracked up graphics card with a picky driver (Intel GMA500, featuring the famous ImgTec PowerVR). Nowadays I use Debian on my notebook, but it will most likely be replaced sometime soon. I went with Debian for obvious reasons: I wanted to drop Ubuntu but hadn’t the time to evaluate what I really want. I really hope to get in touch with BSDs again as I have been a long time FreeBSD user.

I really like fanless systems. I’m frequently checking out ARM based computers, tablets and smartphones, and so I am using Android a lot. I don’t know if I like it or not, I will have a deeper look at it.. someday.

Oh, I do like TinyCoreLinux :)

In what manner do you communicate online?

E-mail is the preferred way to communicate with me. In fact, I even use it for news feeds, task management and my blogging system. I tried a couple of MUAs, ‘nmh‘, ‘mmh‘ and ‘mutt‘, just to name a few. Right now, I am using ‘mutt’, but I am looking for an ‘nmh’/’mmh’ like alternative that handles Maildirs and IMAP. I don’t like programs that take you hostage: Give me my shell back!

I also was very active on IRC, but I dumped it because it — or at least the channels I used to hang out on — didn’t had to offer anything relevant for my life. I don’t like the design of having multiple not interconnected networks, but this feature might just save us one day. Anyways, I reconsider going back to IRC from time to time. My preferred client was ‘irssi‘, but I really liked the way ‘ii‘ works.

At last, there’s XMPP. I used it, I dropped it, I got back to it. I don’t like XML, I don’t like the way how it handle’s some things, but after all it’s the open instant messaging standard, you better support it. Currently, I prepare to drop text messaging (SMS) from my “supported” contact options and replace it with XMPP. My long-term target is to move voice calls as well to XMPP — and later upgrade them to possible video calls. On Android I use the ‘beem‘ and ‘yaxim‘ clients, however I have yet to find one to support all feature from my wishlist; Jingle Audio/Video support can be chippy, just like persistent connections… On the shell, there’s currently only one choice: ‘mcabber‘. However, just like ‘mutt’ It captures your term. There are at least two ‘ii’ inspired clients, one of them is ‘jj‘ — obviously. I even tried to write two XMPP clients on my own: One fed the messages into my mail setup — there are even two kinds of messages types defined by XMPP, mail-like normal and chat — and another one to resemble the ‘talk’ messaging system with a ‘jfinger’ to receive a users xCard. Speaking of xCards: I think letting each user keep it’s own contact information up-to-date is the sane way doing it. Keeping files on persons is just not right, it’s creepy and reminds me of Germany’s history. Besides, you never gonna keep the information up-to-date on your own.

By the way, I don’t do web-based communication, neither Twitter nor Facebook. I think they are bloody awful and are doing harm to humanity. They kill cute kitties and ponies, too. However, I try to evaluate such services every now and then. Buddycloud looks interesting…

Which folders can be found in your home directory?

Having used the same home directory for ages, it has become cluttered and now shows elements from different naming schemes. I really want to clean it up, but I can’t come up with a sane solution. I am currently using some sort of task based naming, but maybe project based would be better? I don’t know.. Oh, and… XDG default names are awful. They brake existing naming traditions. Their scheme is not bad, it’s well thought, but it doesn’t feel right for me.

bin: user binaries and scripts

src: source code

man: manuals, rfcs, technical documents and tutorials

gfx: graphics.. haven’t used it in ages…

mfx: chiptunes :)

mail: mail, tasks, contacts, blog, …

ppt: presentations and talks I have given.. no I won’t rename it to pres…

tmp: temporary files; can be purged after logoff

Desktop: nothing

Downloads: here be dragons… currently flooded with talks/recordings I want to watch..

misc: everything else; sorted

Which paper or literature has had the most impact on you?

I have yet to find the one true thing, the book or paper that catches the essence of how and why. I have been influenced by a lot of papers and persons. I could name a few, but that would be unkind to all those handles I would not include. I actually don’t even care much for names nor bibliographic links, I care for thoughts and ideas.

What has had the greatest positive influence on your efficiency?

I am not efficient at all, but I try to follow inbox zero. I like KISS stuff. I avoid complexity or at least try to brake it up to manageable chunks. Humans and social interaction are a complexity nightmare. They might be efficient for themselves, but me interacting with them or vice verse slows things down. I don’t understand them. That’s where a lot of my efficiency problems come from.

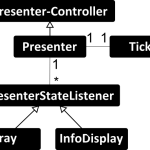

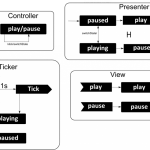

How do you approach the development of a new project?

Tossing around ideas in my head. Scribbling them on a sheet of paper or on a whiteboard. Sort them. Structure them. Look at what is already there. What’s the goal. Talk with people. Listen to people… actually I really don’t know what to say.

Which programming language do you like working with most?

I left the path of a “programmers” many years ago. I spend most of my programming time writing glue code in plain sh. The last few projects I worked on have been done in ruby, as will be my next/last project for university. It wasn’t my decision to use ruby, but it’s an interesting language. I kinda like it and it worked out okay most times. Fair enough, but I don’t know if I really stick with it.

In your opinion, which piece of software should be rewritten from scratch?

Hardware sucks, software sucks, implementations are bad and most standards are even worse. I complain a lot because something might not fit my view/guidelines. But it doesn’t matter. Don’t fix software, fix humanity. Seriously, why can’t we all be a little nicer to others?

What would your ideal setup look like?

Actually, I don’t know. Small, no bloat, sane. I could write a lot about CLI, X and what’s wrong or right. But a more fundamental question I still have to answer is whether I want a client/server setup — a dump client and a freedom box in every house, meshed wireless networking, controlled by the people and not the government or corporations.. — or a complete road-warrior setup, where everything is right on my notebook. Do I want a notebook at all? Or could I use a smartphone/tablet/$futuredevice with an external keyboard? I don’t know..

Click here for the full picture.